无

”Python txt文件 去重“ 的搜索结果

Python数据处理工具

主要介绍了Python实现的txt文件去重功能,涉及Python针对txt文本文件的读写、字符串遍历、判断相关操作技巧,需要的朋友可以参考下

利用Python将txt文件批量去除重复行内容

因为整理字典,需要将多个txt文件合并且完成去重操作,此为第一版没有完成参数化,但实用性还可以。

原博文2020-02-14 13:20 −Python实现的txt文件去重功能示例更新时间:2018年07月07日 09:00:36 作者:人饭子 我要评论这篇文章主要介绍了Python实现的txt文件去重功能,涉及Python针对txt文本文件的读写、字符串遍历...

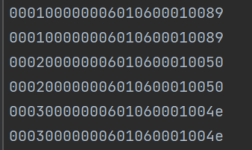

一、生成待去重数据每行是固定位数的数字串import osfrom random import randint#-- from u_工具 import *print("———— 开始 ————")#-- 打点()# 用来配置的变量位数 = 13行数 = 500 * 10000输出目录 = "./a_...

可以使用 Python 的 set 数据结构来去重文件中的行。 首先,打开文件并读取每一行,将每一行添加到 set 中。由于 set 中的元素是唯一的,因此会自动去重。然后,将 set 中的元素写回文件即可。 下面是一个示例代码:...

/bin/python3 original_list1=[" "] original_list2=[" "] original_list3=[" "] original_list4=[" "] newlist1=[" "] newlist2=[" "] newlist3=[" "] newlist4=[" "] newtxt1="" newtxt2="" newtxt3="" newtxt4="...

python编写的一些测试可以用到的小工具 会持续更新这个小工具系列哦~

一、生成待去重数据 每行是固定位数的数字串 import os from random import randint ...输出文件 = f"{输出目录}/随机数.txt" # 预处理 _00 = "".join(["0" for i in range(位数 - 1)]) _100 =

如下所示: # -*- coding:utf-8 -*- ... target_dir = '/data/u_lx_data/fudan/muying/python/uid_regular_get.txt' uset = set() #去重 print(开始。。。。。) print(datetime.now().strftime('%Y-%m-%d %H:

本文实例讲述了Python实现的txt文件去重功能。分享给大家供大家参考,具体如下:# -*- coding:utf-8 -*-#! python2import shutila=0readDir = "/Users/Administrator/Desktop/old.txt" #oldwriteDir = "/Users/...

一、生成待去重数据每行是固定位数的数字串import osfrom random import randint#-- from u_工具 import *print("———— 开始 ————")#-- 打点()# 用来配置的变量位数 = 13行数 = 500 * 10000输出目录 = "./a_...

第一次学习py下的py最新版然而网上相关教程都是老版,各种语法错误(纠错使人印象深刻),也许效率不高,但是基本拿来就能用. 根目录下所有txt一次性合并去重,太大了跑的可慢了。。

python对文件内容的去重 文章目录python对文件内容的去重前言实现步骤总结 前言 很多时候我们获取的数据存在大量重复,重复数据在进一步处理时会降低处理效率,且可能导致错误,因此内容去重是数据处理一个重要...

python去重txt文件中指定的内容或者相同的内容

本文实例讲述了Python实现的txt文件去重功能。分享给大家供大家参考,具体如下:# -*- coding:utf-8 -*-#! python2import shutila=0readDir = "/Users/Administrator/Desktop/old.txt" #oldwriteDir = "/Users/...

每行在promotion后面包含一些数字,如果这些数字是相同的,则认为是相同的行,对于相同的行,只保留一行。接下来通过本文给大家介绍Python做文本按行去重的实现方法,感兴趣的朋友一起看看吧

如下所示:# -*- coding:utf-8 -*-from datetime import datetimeimport redef main():sourcr_dir = '/data/u_lx_data/fudan/muying/muying_11yue_all.txt'target_dir = '/data/u_lx_data/fudan/muying/python/uid_r...

刚开始不明白为什么最后111还能被添加进去,调试后发现最后一个111没有换行符号,程序认定他们不一样,...2.读取需要去重的文件,将文件循环去重写入另外一个问题里面。1.输入数字,放在列表中,先进行排序,然后去重。

代码也是在网上找的,效率挺不错的,特别适合字典文件的去重#coding=utf-8import sysdef open_txt(): #打开TXT文本写入数组try:xxx = file(sys.argv[1], 'r')for xxx_line in xxx.readlines():passlist.append(xxx_...

PYTHON简单代码去除TXT文档重复行内容去重复 fi = open('test.txt', 'r') # 打开需要处理的test.txt。 txt = fi.readlines() with open('test_OK.txt', 'a') as f:#创建处理去重复后的结果保存文档,防止找不到文件...

{"moduleinfo":{"card_count":[{"count_phone":1,"count":1}],"search_count":[{"count_phone":4,"count":4}]},"card":[{"des":"阿里云文件存储NAS是一个可共享访问,弹性扩展,高可靠,高性能的分布式文件系统。...

本文实例讲述了Python实现的txt文件去重功能。分享给大家供大家参考,具体如下:# -*- coding:utf-8 -*-#! python2import shutila=0readDir = "/Users/Administrator/Desktop/old.txt" #oldwriteDir = "/Users/...

import os # 合并函数 def merger(files_path): try: # 返回目录下所有文件名 ... # 打开一个文件装下所有数据 with open(bigfile_path, 'wb') as bigfile: print('开始合并。。。') # 循环每一个文件名 fo

【代码】python把txt文件里重复数据去重代码。

【代码】txt文件去重。

推荐文章

- php 上传图片 缩略图,PHP 图片上传类 缩略图-程序员宅基地

- scrapy爬虫框架_3.6.1 scrapy 的版本-程序员宅基地

- 微信支付——统一下单——java_小程序统一下单接口-程序员宅基地

- (已解决)报错 ValueError: Tensor conversion requested dtype float32 for Tensor with dtype resource-程序员宅基地

- 记录el-table树形数据,默认展开折叠按钮失效_eltable一刷新展开的子节点展开按钮消失-程序员宅基地

- 设计模式复习-桥接模式_csdn天使也掉毛-程序员宅基地

- CodeForces - 894A-QAQ(思维)_"qaq\" is a word to denote an expression of crying-程序员宅基地

- java毕业生设计移动学习网站计算机源码+系统+mysql+调试部署+lw-程序员宅基地

- 14种神笔记方法,只需选择1招,让你的学习和工作效率提高100倍!_1秒笔记 高级-程序员宅基地

- 最新java毕业论文英文参考文献_计算机毕业论文javaweb英文文献-程序员宅基地